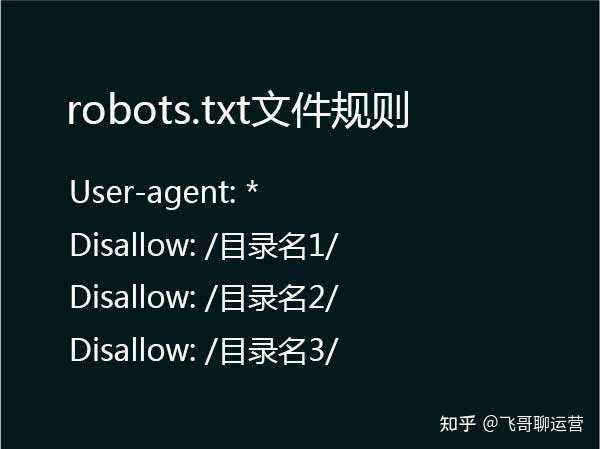

摘要:如果/robots.txt是一个空文件,则对于所有的搜索引擎robot,该网站都是开放的。一个网站的所有URL默认是Allow的,所以Allow通常与Disallow搭配使用,实现允许访问一部分网页同时禁止访问其它所有URL的功能。

在未来五年内(即2024年),更新后的robots.txt协议将再度引起大众关注。该文件以TXT格式表述,清晰明了地指示搜索引擎抓取特定页面,已经逐渐升格为抓取站点内容的必经文档。

随着网络发展迅猛,搜索引擎成为获取信息的重要途径,站长也开始关注如何控制搜索引擎机器人的访问权限。为了适应这种需求,robot.txt协议应运而生。

每一个网站,在其官方主目录中robots 禁止百度收录,都会包含一项被称为"robots.txt"的独特文档,它是专门为网络爬虫设计的。在爬行过程中,搜索引擎的蜘蛛会首先检测这个文件是否存在。倘若已经发现了这份文档,它们将会依循其中所指定的规则来规范对整个网站的查探行为;否则,爬虫可以随意进入没有其他安全防护的页面进行浏览。

在本文档内,信息展示形态以User-agent为前缀的单独条目或批量模式为主导,紧随其后的便是Disallow关键字。前者主要用作提示搜索引擎资源识别功能,而后者用以明确声明禁止访问哪些特定的URL路径。例如,“Disallow:/help”这一指令明确指出了不应让搜索引擎爬取/help.html及/help/index.html两个目录。

在本文件中,可以利用"Allow"一栏为指定Web地址设定相应的开放权限。其作用相当于"Disallow"的禁止功能,相反的,"Allow"则批准了爬虫对特定URL资源的访问。通过恰当地设定 "Disallow"和"Allow"参数,管理者能灵活地允许某些网页查询,并阻挡其他URL的访问。

资深网络安全专家明确指出,"robots.txt"协议作为网站管理措施,有效限制了搜索引擎蜘蛛的部分访问权限,从而在确保数据隐私和网站安全性方面发挥重要作用。

根据近期数据呈现,各大引擎普遍采用 robots.txt 协议以规范自身网站搜寻爬虫的入站规则,此举旨在确保网站数据安全和私密性,同时提高站点使用体验和用户满意度。

追溯到1994年初创时期的互联网初期阶段robots 禁止百度收录,Bot协议应运而生。经过近三十年的发展与演进,该协议已然成长为网站管理领域的关键工具。同时,网络空间的持续扩展以及搜索引擎技术的不断升级也对其产生了深远影响。

某知名搜索引擎运营商明确强调:鼓励企业利用 robots.txt 策略,科学设定搜索引擎蜘蛛的访问权限,以确保网站数据安全性和隐私权不受侵害。

在网络科技日新月异的发展下,搜索引擎对网站的访问覆盖率逐渐上升至至关重要性。利用并合理编写Robots.txt协议,网站运营商能精心管理站务,提升用户满意度。

面对互联网狂潮,确保网站隐私和安全性至关重要。高效使用Robots.txt协议,不仅守护站点安全,还优化用户体验,展示其构筑稳健可靠网络环境的核心角色和价值。

真诚邀请广大读者在本专栏评论处分享您对 robots.txt 协议的独特理解以及应用实践经验,共同研究保障和增强网站私隐性以及安全性的有效手段。我们期待能借助您的专业视角,让更多人注意到并重视这一有力的网络管理工具。