摘要:搜索引擎为什么不收录网站内页robots禁止了搜索引擎抓取大家别认为没有这种情况,作为站长我们必须要知道搜索引擎来到网站首先访问的就是robots文件,如果使用robots禁止了抓取,不管你怎么提交链接都是不可能收录的。robots协议禁止的搜索引擎抓取;

在网络时代,网站内容质量已经是决定网页是否能被搜索引擎收录的重要因素。为了提高用户满意度及SEO效果,提升内容吸引力极其关键。本文将深入探讨如何提升网站内容品质robots 禁止百度收录,从而使搜索引擎积极收录您的页面。

搜索引擎为什么不收录网站内页

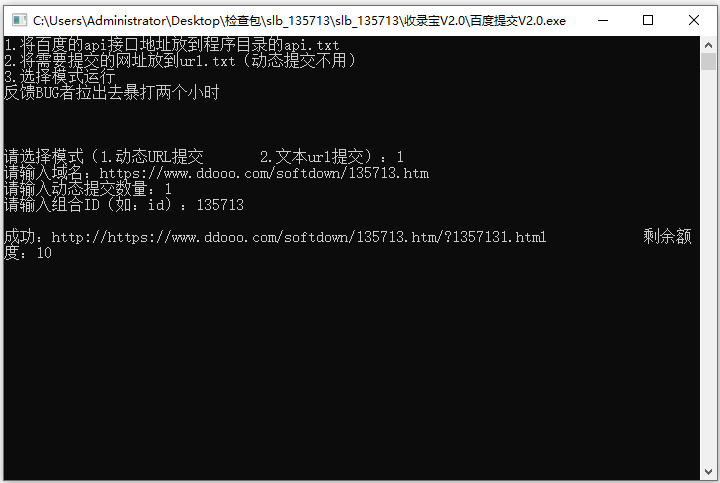

搜索引擎内容抓取方式主要有自动与手动两种,此外,主动推送技术亦能提高长期未被索引站点在搜索引擎中的可见性。然而在实践过程中,即使已手动提交链接也可能出现未能被展示的现象,其成因可能涉及到robots协议禁令、网站内容质量缺陷、搜索引擎抓取失败、配额限制及网站安全等诸多因素。

robots禁止了搜索引擎抓取

Robots协议乃搜索引擎优先审查之重要文件,若被明确设定禁索引,则提交亦无效。因此,应仔细核对Robots文件,确保允许搜索引擎获取所需内容。

网站内容质量是否优质

随着搜索引擎技术不断革新,其对网站所呈现之优质度要求日趋严格。高质内容能够吸引众多用户驻足,同时更易于受到搜索引擎推崇。故而,在策划网站内容时,应当深度研究和满足特定领域知识,以满足用户需求。

搜索引擎抓取失败

尽管您仍可顺利阅览相关网页,但搜索引擎在获取及索引数据时可能会因网站空间的不稳定而受限。因此,网站运营的稳定性对于搜索引擎抓取内容至关重要。

配额限制

尽管搜索引擎对主动推送的抓取配额有明确限制,然而过大尺度的新增信息可能会导致采集或抄袭之嫌。因此,我们在开展网站推广之际需严格遵守相关规定robots 禁止百度收录,不断创作并充实优质内容的同时,避免采用任何不当的黑帽SEO手段。

网站安全

恶意攻击易使网站产生大量不佳信息,严重影响搜索引擎的抓取和收录。故而,在网站建设全过程中必须重视及加强安全防控,以免遭受攻击。

页面权重达不到收录标准

每一个网页皆具自身独特的权重值,此权重受到多项因素如内容质量、用户需求及布局设计等多方面影响。若页面对应的权重未能达标,便有可能导致该页难以被搜索引擎收录。

网页能否被搜索引擎接受取决于诸多因素,例如,机器人协议规定,原创性,抓取失败,配额限制,安全性及页面权重等。因此,只有全盘考虑并适当应对上述挑战,才有望提高网页被主动收录的可能性。