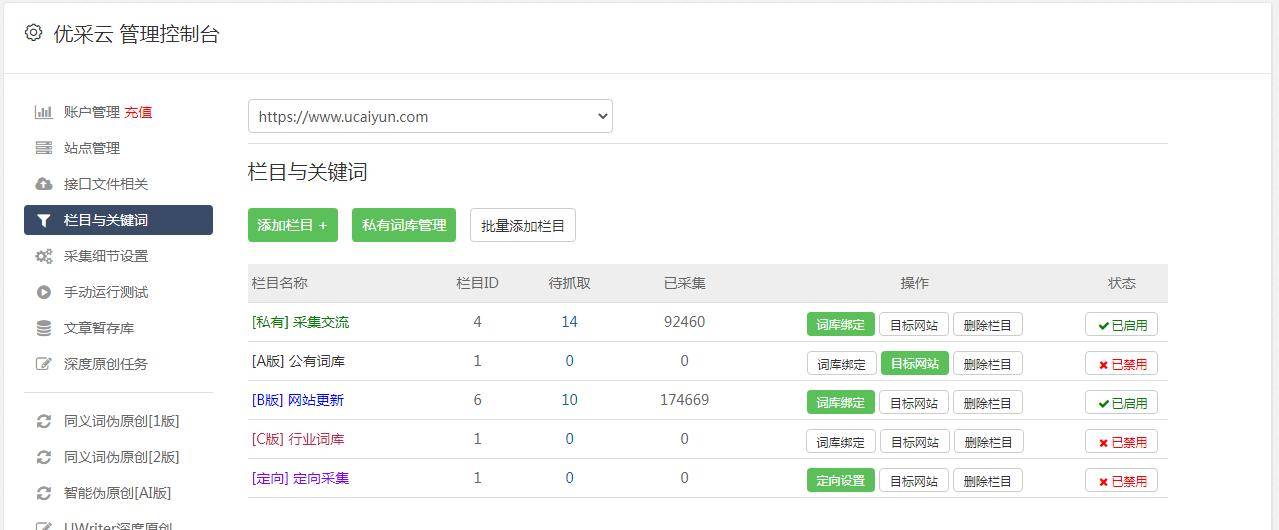

摘要:第三步,将我们的网站提交到百度站长后台(如果你已经提交过百度站长工具后台,那么你可以跳过这一步),如图:接下来我们把网站里的所有页面都提交一遍,不过一般我们建议仅需要提交网站的主要目录页面就可以,其他的页面我们可以通过站点地图来提交;

在SEO优化实践进程中,百度对网站的封锁一直备受广大站长们的关注与讨论。对于这一难题百度收录反馈,部分人也许会感到困惑并无从下手。然而,凭借我积累的丰富实战经验,我愿意提供以下可能有帮助的建议,以供各位同仁借鉴。

彻底检查和梳理网站

首要任务即对网站进行全面而深入的评估与整理,涉及网页内容的重新审核及不适宜百度收录标准部分的修正。鉴于百度K站往往由违规内容引发,该环节至关重要。

对于网站的内容要严格审视,确保其新颖独特以及有实用价值。一旦发现大量抄袭及粗制滥造内容,或缺乏实质性信息,均需立刻处理并改进。同时,对外链质量也须保持关注,避免不必要的不良连接及其对网站排名与收录的负面作用。

提交网址给百度

步骤二,通过百度搜索引擎深入探寻站点地址,同时自动将其递交予百度,从而提高识别精度及收录效率,进一步增加网站在搜索结果中的曝光率。

在完成百度网站注册后,推荐您同步申请使用百度站长工具服务。此项服务能更精确地监测及改进贵公司网站在百度搜索引擎上的表现,随时发现并解决潜在问题。

利用百度站长工具进行优化

在关键的第三步骤中,我们将运用百度站长工具对网站进行全面的优化提升。首先,请登录并切换至“数据监控”界面;随后启动“抓取诊断”功能,输入贵网站主页链接。接下来,您便可详细查看百度蜘蛛抓取后生成的相关信息。

在提交首页绝对地址后,为了更全面地展现网站信息,可持续向百度搜索引擎推送其余网页,从而完成全站内容采集。通常应首选提交主目录页面,至于剩余页面,则可借助站点地图的辅助来完成相关操作。

检查和优化Robots.txt文件

第四步需严谨检查并剔除所有潜在的误判因素,以确保网站的robots.txt文件准确无误。该文件作为网站与爬虫间的检索控制信息交换桥梁,其可影响爬虫抓取网页的准确性,从而直接决定了网络索引质量。

对Robots.txt文件应严密审校,防止语法及规则缺陷;出现问题当立即修复与精炼,保证搜索引擎蜘蛛顺畅访问及提取得网站信息。

提交站点地图

第四步,利用合适工具创建并上载至网站主页的站点地图(xml格式)。此图旨在向搜索引擎蜘蛛展示网站架构与主要内容,从而提高其对网站信息的精准抓取及索引效率。

完成站点地图建立及最佳包装后,务必通过百度站长工具平台进行提交。此举有助百度搜索引擎精确检索并收录网站信息,全面提升网站在百度搜索排名及竞争力。

利用SEO工具吸引蜘蛛抓取

运用SEO蜘蛛侠V3.01这类具有强大SEO功能的工具可以有效引起搜索引擎的注意并获得其抓取我公司网站的机会。此类软件能够模拟搜索引擎爬虫行为,快速精准地找出并解决可能出现的问题,从而显著提升我公司网页被搜索引擎收录的速度与质量。

SEO工具有助于及时察觉并解决网站技术及架构缺陷,进一步提高搜索引擎排名及展示效果。此类工具的核心功能是深入剖析搜索引擎运作机制,高效优化网站架构与内容质量,以提升用户体验及网站价值。

分享经验与解答疑问

本篇文章是在处理类似百度K站这样复杂问题上积累的丰富实践经验基础上编写而成,旨在为各位同仁在遇到类似窘境时提供一些借鉴和指导。若有其他疑虑,敬请随时与我取得联系,本人将尽心尽力地回答并施以援手。

面临百度K站这一危机挑战,作为SEO团队成员,我们必须迅速采取恰当战略举措,精准找出问题并予以修复百度收录反馈,以提高网站在搜索引擎中的曝光与排名。期望各位共同探索SEO创新,推动网站流量增长,创造更多商业价值。