摘要:核心提示:百度蜘蛛只爬网站的首页不爬内页,这是怎么回事?百度蜘蛛只爬网站的首页不爬内页,这是怎么回事?首先解决一个问题,怎么知道“百度蜘蛛只爬网站首页不爬内页”?“百度蜘蛛只爬网站的首页不爬内页”原因有如下:那肯定就是上面7条原因中的某一条或者N条,导致了“百度蜘蛛只爬网站的首页不爬内页”。

改善网站对于提升网站声誉和流量具有决定性影响,而包括百度在内的国内顶级搜索引擎的网络爬虫行为对网站被收录的程度有直接影响。然而,部分网站管理者和SEO专家发现,百度蜘蛛只爬取首页,忽略了内页,这引发了业界的广泛关注和猜测。本文将深入探讨此问题的原因,并提出相应的解决方案。

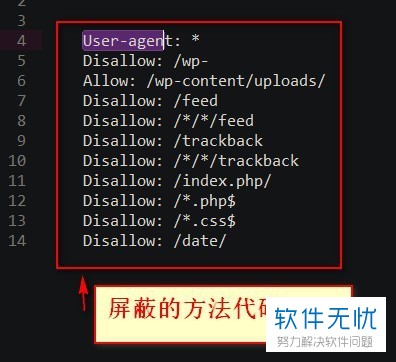

robots.txt文件的设置

确立优质robots.txt对于保障百度蜘蛛的网页抓取至关重要。该文文档位于网站根目录之下,它能指导搜索引擎蜘蛛是否被准许浏览特定网页。若robots.txt设置不妥,如不当拒绝内部链接页面,将可能致使百度蜘蛛仅收录首页内容,而忽视内页信息。因此,站长在编制robots.txt时需仔细检查新站百度不收录首页,以防误封禁内页。

作弊行为的影响

首要问题是,不正当的优化手段可能使百度只抓取网站首页。部分SEO从业人员使用群发等违规技术提高排名,这种做法容易被百度发现且受到惩罚,从而让蜘蛛只能停留在网站首页,忽略了其他页面。因此,站长应该坚决避免任何作弊行为,以防止对网站索引产生负面影响。

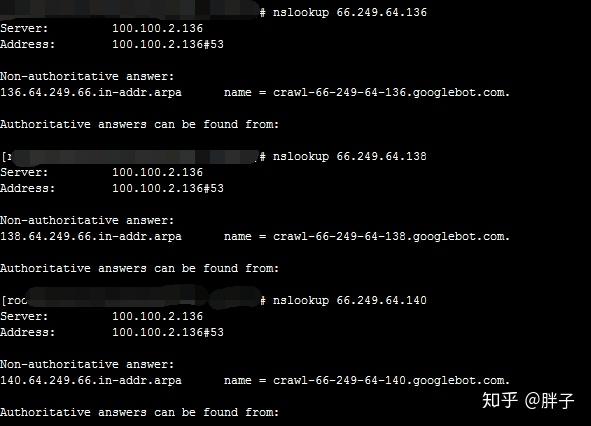

服务器问题

首先,服务器故障往往是导致百度蜘蛛只爬取首页的重要因素。若服务端效率低效或是运行不稳定,都可能中断蜘蛛的正常爬取行为。再者,同一IP服务器上的其他网站因违规受罚,也可能对自身网站的收录造成间接冲击。因此,面对这类情况,站长应迅速确认服务器状况,确保其正常运作。

网站结构和质量问题

另外,网站架构以及质量也会直接影响到百度爬虫的抓取行为。如站点导航不清晰,内部链接匮乏,或网页质量低劣,百度爬虫可能仅抓取首页,忽略其他页面。因此新站百度不收录首页,站长需积极调整网站结构,提高网站质量,以增加内页被收录的机会。

网站沙盒和新站效应

新站上架之际,百度蜘蛛常仅爬取首页,源于其仍处于搜索引擎的沙盒效应之中,或是尚未发展完善。于此境地,站长需保持耐心,悉心填充网站内容并优化结构,以此提升站点的权重,引导百度蜘蛛深入检索内页详情。

解决方案

综合各专家意见,对于百度搜索引擎仅抓取首页内容而忽视其他页面的现象,我们提出如下解决策略:

严谨审查robot.txt文件配置,以防内部页面访问受阻。

严格抵制各类欺诈行径,确保网站内容具备创新性及高品质特点。

务必常检视服务器稳定性,保证其流畅运作,防止服务器故障对搜索引擎爬虫采集带来不利影响。

优化网站结构以提高质量,并增加内部链接以助于深层抓取内页的搜索引擎蜘蛛。

对于新设立或处于沙盒状态下的网站,需持之以恒地优化其内容与结构,从而提升网站权重。

执行以上策略后,可有效解决百度蜘蛛只读取首页而忽视其余页面的问题,提升网站的收录与展示机会,为促进网站发展打下坚实基础。