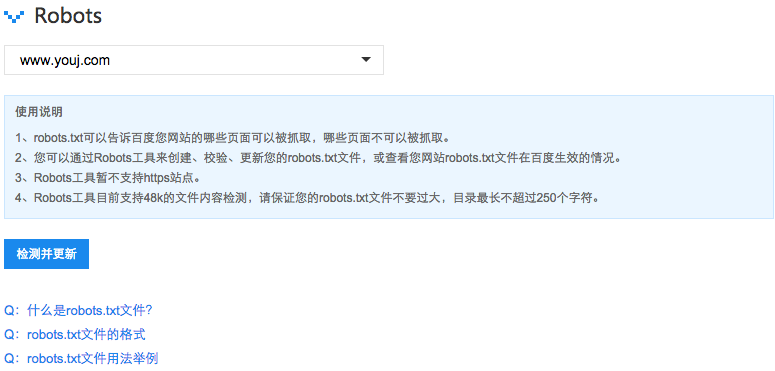

摘要:最后需要说明的是:百度会严格遵守robots的相关协议,请注意区分您不想被抓取或收录的目录的大小写,百度会对robots中所写的文件和您不想被抓取和收录的目录做精确匹配,否则robots协议无法生效。

在瞬息万变的互联网时代,搜索引擎已成为用户获取信息的首选途径。然而,部分网站管理者却不愿让其特定内容被搜索引擎收录。为妥善处理此问题,我们需充分发挥robots.txt文件的指引功能。本篇文章将详细探讨robots.txt文件的作用、结构及有效应用方法,助力站长精确掌控网站内容辐射范围与影响力度。

1.Robots.txt文件的作用与必要性

Robots协议(又名Robots.txt),乃放置于网站主目录内之文本文档,目的在于指引搜索引擎接触正确的网页。此协定为站点管理员提供了关键价值,尤其对于处理涉及复杂动态内容或含有敏感信息的网站,其隐私与数据安全保障尤为必要。

为保障搜索引擎正常访问及适度展现网页内容,建议运用robots.txt工具。但请注意,仅在确有无需搜索引擎收录之信息时方可创建该文件,以免影响期望搜索引擎完全掌握的网站运营效果。

2.Robots.txt文件的结构与语法

机器人响应规则文档内包含若干行记录,各行间以空格分隔。每行包含至少三个基本要素:User-agent,Disallow及Allow。User-agent用于限定受限的抓取工具;Disallow指定禁止的特定网址;而Allow则确认允许访问的网站范围。下文将针对这些关键元素进行详细解读。

通过创建有效的robots.txt文件可规范特定爬虫的使用。若应对多类爬虫进行限制robots 禁止百度收录,则须单独设立对应User-agent规则。通常,除了通用规则外,还需设置针对具体爬虫的特定条款。

禁用条款:本条款严格定义了URL的访问权限,其具体数值覆盖全路径及其不包含空格的子集。数值为该值的URL将会被指定爬虫禁止检索。

授权参数:此项指明可由爬虫访问的URL范围,允许通过设置完整路径或路径前缀来实现。在"许可"栏目的值作为开启相关URL权限的标志。

请务必牢记,当存在Disallow与Allow两组限制时,前者拥有更高优先权并能覆盖后者。在这类情形中,即便某URL同时符合Disallow及Allow的规则,但其实际访问权限仍旧受Allow设置所主导。

3.Robots.txt文件的配置示例

本文将通过一个简单的实例向您介绍如何精确调整robots.txt文件以限制网页在搜索引擎中显示。举例来说,若某个站点中有部分内容需要保护,但是又希望其他信息能被搜索引擎收录,那么可以按照以下步骤编写robots.txt文件:

plaintext User-agent:* Disallow:/private/ Allow:/public/

本例中,"User-Agent"参数决定了所有爬虫请求能否通行;"Disallow"则用于详细指定特定URL路径名(如"/private/")不予收录;而"Allow"功能则是为特定已筛选出的URL路径名(例如"/public/")授予访问权限。其余页面将默认允许收录。

4.Robots.txt文件的高级配置

robots.txt不仅包含基本配置,更有应用通用匹配符实现关键词检索等高阶功能。对于不同类型的爬虫或特定URL,精确定位的策略显得尤为重要。

在实际应用中,百度蜘蛛所具备的“*”和“$”通配符功能,能够实现URL进行模糊匹配。这对于设定某路径下的全部文档权限或仅允许特定文件类型访问等具有重大意义,可作为一则实例予以例证。

User-agent:Baiduspider

Disallow:/admin/

Allow:/public/*.html

该示例设定了百度蜘蛛在/public/路径内,获取所有以'.html'后缀的网页内容,以确保不会访问到/admin/目录。

5.Robots.txt文件的注意事项

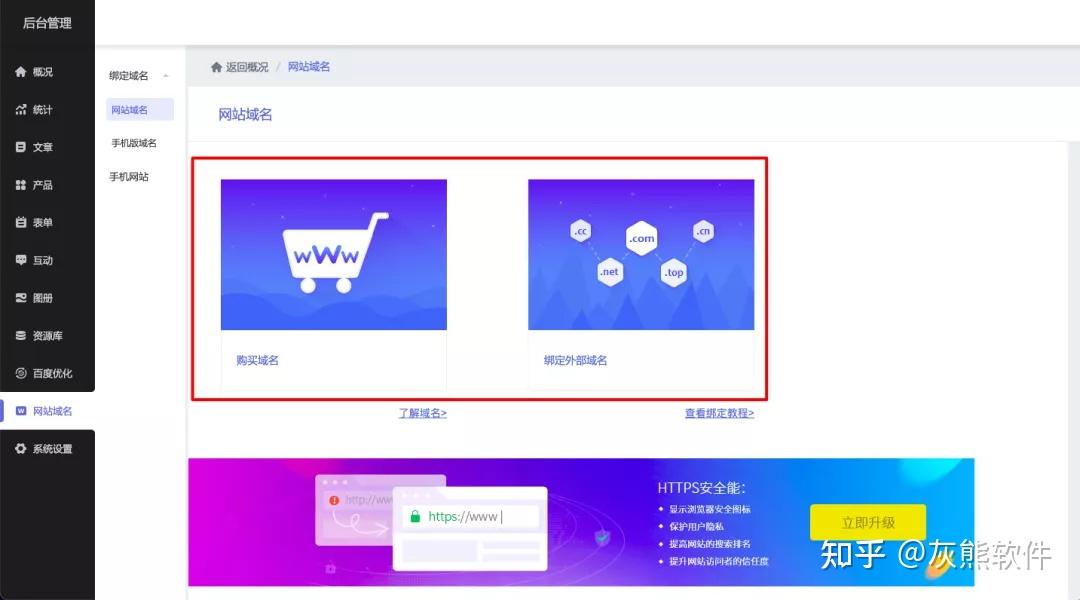

编撰robots.txt之际,务必关注并尽力规避以下问题:将文件置于网站的根目录,命名为“robots.txt”;遵循良好习惯,确保行尾及列间冒号和空格的使用无误;谨慎处理通配符的应用robots 禁止百度收录,防止过度限定或无意中的数据泄露。

当务之急是每隔一段时间对机器人.txt文档进行全面检查并及时更新,确保与其所在的网站内容无缝配合。鉴于网站频繁更迭和发展,应对机器人.txtext文件保持高度的关注并随时根据需要进行调整,以便更好地迎合新的需求和规则要求。

6.Robots.txt文件的作用范围

Robots.txt主要针对搜索引擎的蜘蛛程序,作为一种公开但看不见的抓取规则向公众展示。它对此类使用者无丝毫影响,仅能引导搜索引擎的蜘蛛程序完成索引工作。

7.Robots.txt文件与SEO优化

充分认识和运用robots.txt对SEO优化的影响至关重要。适当调整此文件可以显著提升网站在搜索引擎中的排名,从而扩大品牌认知度及访问流量。合理控制页面收录状况,有助于搜索引擎更关注核心内容,全面提升网站名次及其可见性。

以全方位掌控Robot.txt文件设置、网站架构设计与关键字配比等SEO策略为基础,追求最优效果。唯有精细组织和持续改进每一环节,方能在搜索引擎排名竞争中脱颖而出,提升访问量及点击率。