摘要:一、robots.txt是什么?二、robots.txt的作用/admin/abc.html(允许蜘蛛爬去admin目录中的abc.html页面)3、禁止抓取/abc/目录下的所有以.htm”为后缀的URL(包含子目录)

在数字技术领域,搜索引擎优化(SEO)是提升网站知名度和成长性的关键因素。其中,机器人文本文件(ROBOTS.TXT)作为SEO策略的重要组成部分,对于网站管理员来说有着不可忽视的作用。通过阅读本文,我们将详细探讨机器人文本文件的功能特性、语法规则以及其在搜索引擎优化中的重要性,希望能够为各位读者提供深入了解和正确使用这项工具的专业指引。

1.robots.txt文件的基本结构与语法

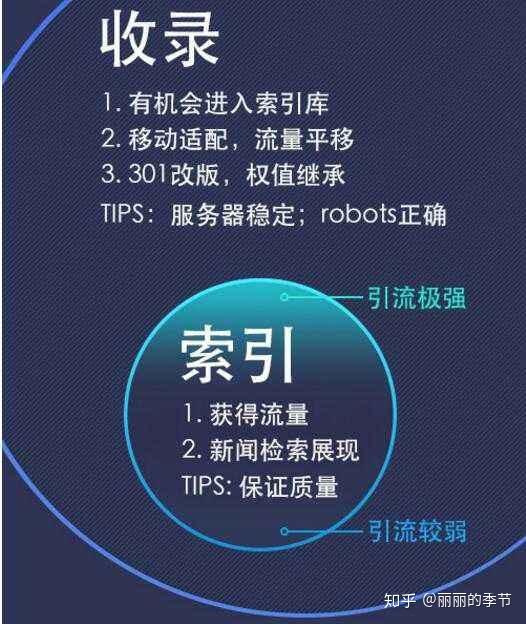

Robot.txt即是网络爬虫规避准则协议的落地实现,默认为根目录保存。该文件通过特定语法规范百度会收录动态页面吗,明确指示搜索引擎允许抓取及必须忽略的页面信息。其中涉及以下几个关键词:

-用户代理:用于识别搜索引擎爬虫如谷歌爬虫和百度蜘蛛,以帮助站长制定针对性的爬取策略。

-Disallow:用于设定无法被爬虫读取的网页和路径;其后可增加被禁止访问的路径列表,每个路径之间使用回车进行分隔。

-Allow:设定可被采集的网页或子目录,需提供完整路径。

请务必保证Robots.txt代码书写规范,包括以下几点:关键词带冒号及空格,路径使用斜杠表示且与关键词间留有空格,注意文件名大小写敏感性。

2.robots.txt文件的应用场景

robots.txt文件广泛应用于诸多行业,主要目的包括以下几点:

-利用robots.txt,管理搜索引擎蜘蛛访问权限:网站管理员可以使用Disallow指令来限制搜索引擎蜘蛛检索和索引敏感信息,例如个人隐私、收费内容等。如此操作有助于保护网站安全性与用户隐私权益。

-优化索引策略:依据Allow规则进行精准设置,便于搜索引擎爬虫捕获关键资讯,助推搜索排名。例如,适度开放产品与新闻页抓取权限,以增加其被索引机会。

-网站改版和URL调整策略:当网站进行大规模的修缮或是重新架构网址组合时,存有大量无效或链接至新内容的旧链。此时,应用robots.txt可暂时阻止这些链接运作,从而避免影响搜索排名和平稳的用户体验。

3.robots.txt文件的高级应用技巧

除了常见的Disallow和Allow规则,使用robots.txt还能深入优化网站的搜索引擎表现。其中主要的操作如下:

-优化主要搜索引擎抓取控制:根据不同搜索引擎的特性百度会收录动态页面吗,定制具有针对性的禁止与允许规则,有效提升各平台网站显示效果。如授权给予Googlebot访问某些特定页面,同时限制BaiduSpider同样的访问权限,以迎合和应对各搜索引擎特有的算法及爬虫策略。

运用通配符号:在robots.txt文档中,运用星号(*)与问号(?)作为通配符。前者涵盖任何字符顺序,后者代表任一单个字符。巧妙运用这些通配符,使得规则匹配更具灵活性,规则数量大幅减少,提升了文档阅读体验。

-结合RobotsMeta标签:除借助robots.txt来规范爬行外,亦可用RobotsMeta标签进行网页细微操控。在此机制下,特定网页可以被通知不被访问,或者禁止其页面内容作为锚点继续爬行。尽管该方法可精细化管理页面,但同时也需花费更多精力。

4.robots.txt文件的编写与调试技巧

在对Robots.txt进行编辑和验证时,应采取以下策略来提高效率并确保文件的精确性和有效性。

使用线上工具检测语法规则:鉴于机器人协议文本对于语法要求严格,极易出错。建议采用在线机器人协议文本审查工具,快速识别并改正其间的语法规则错误。

-规则有效性层层检验:在编写严谨的robots.txt文件时,应采用逐步添加规则并对其效果进行审查的方式。此举能够迅速修订和补充内容,确保文件准确无误且完整无缺。

-利用搜索引擎抓取工具测试效能:Robots.txt设置妥当之后,通过搜索引擎提供的工具模拟爬虫行为进行效验,以此优化规则,提高网站的抓取效率。

5.结语与展望

随着信息时代的到来,搜索引擎优化成为网站成功发展的关键手段之一。特别是Robots.txt文件,在SEO策略中发挥着举足轻重的作用,对网站排名与展现效果起到至关重要的影响。适当设置Robots.txt文件将有助于提高网站在搜索引擎中的点击率,从而吸引和保留更多用户,推动网站持续稳定地发展壮大。

然则,鉴于搜索引擎技术瞬息万变,Robots.txt文件的编写和优化亦需应对新型挑战并抓住新生机会。面向未来发展,我们期盼能出现更智能化、个性化的Robots.txt文件生成工具,协助站长更精准实现搜索引擎优化要求,从而推动网站稳健发展。

在这个充满挑战和机遇的时代背景下,让我们齐心协力,不断深化研究与发展,为推动网络世界的繁荣贡献力量。