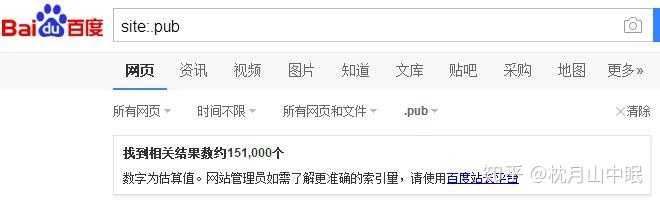

摘要:单,而且有的只会收录首页不收录内页,甚至长达一两个月也不收录内页,如下图,这可能是百度算法的一个新调整,那么为什么新站只收录首页不收录内页呢,一起来看下。协议,而今天所讲的是内页不收录也是一样的,因为站长也可能把内页禁止了而没发现,或者robots.txt写法错误但没发现。

针对新网站仅收录主页而未涉及到内部页面的问题,许多站长颇为关注并感到困扰。尽管搜索引擎曾普遍快速收录新站点,但如今,尤其在百度上,收录状况显得较为严峻,甚至存在仅有主页被收录的情况。本文将分别从多个角度剖析此种现象的成因新站百度不收录,并提供对应的改进策略以供参考。

建立信任期

了解谷歌的“沙盒效应”,即网站在一段时间内有收录限制,须经历信任建立期以提高排名与收录率。百度同样设有相似机制——“信任建立期”。在此阶段,百度对待新站的收录较为严格,耗时较久。因此,百度常先收录新站首页,因其权重较高;而内页收录则需更长的信任建立期。站长可通过分析网站日志,关注蜘蛛爬行状况及返回的状态码(如200、400或404),以此判断是否处于百度的信任建立期。

在这一过程中,站长需耐心等待,持续优化网站内容与架构,提升用户体验及其价值,从而俘获百度之心。唯有坚持不懈地努力与优化新站百度不收录,方能逐步脱离信任建立期的束缚,赢得优良的收录及排名。

文章质量问题

新站内页收录受文章质量制约,因其提供的信息必需有价值、有效、满足用户需求。故内容质量欠佳之网站,难获搜索引擎垂青。对于新站点而言,优质内容至关重要。

首要任务,站长需确保网站内容具备一致性——发布的文章须紧密围绕站点主题,遵循目标用户的需求。同时,文章的质量亦显得尤为关键,涵盖了准确性、特殊性及深度等方面。站长不应用采集文章或使用伪原创工具来补充网页内容,而是要注重创作的创新性以及文章的品质,以满足用户对高价值信息的渴求。最后,文章的可读性不容忽视,即要保证内容组织合理、语句通畅易于理解,以便吸引并留住用户进行阅读和分享。

站长应高度重视网站内容的创新与精进,持续提高内容质量,以提升SEO凭证并吸引更多用户。唯有注入真髓与魅力的内容,方可赢得搜索引擎及用户青睐。

robots.txt协议

对于初涉建站领域的站长而言,robots.txt协议或许易被忽略,然而其地位至关重要。此文件旨在规范搜索引擎机器人的爬行模式,通过科学配置该文件,可掌握搜索引擎机器人对站点的访问权限,即哪些页面可供爬行,哪些禁止。

然而有部分站长在新建网站时,因机器人文件(robots.txt)的设置疏忽,致使蜘蛛难以正常抓取内容。尤其对于网站架构不成熟的新站点,站长或许会选择暂时屏蔽蜘蛛,待架构完整后解除限制。然而需注意,此类操作即便蜘蛛成功访问,若机器人文件配置欠妥,依旧会影响搜索引擎的收录情况。

由于错误配置robots.txt可能仅允许搜索引擎索引主页,忽视内页爬取,从而导致内页未被收录,故站长初设应谨慎设定,保证搜索引擎能畅通无阻地访问全部网页,以免影响网站收录及排名。

总结

尽管新站仅收录首页让人困扰,然而,仍有方法改进收录状况并提升网站排名与流量。

首要之事,站长需尊重并耐心等候百度对其的信任门槛设定期间。此间,务必持续优化网站内容和架构,提升用户体验与价值,以获取搜索引擎的信赖及认同。接着,网站文章质量至关重要,务必保证其相辅相成、优质完备并且易于理解。唯有如此,方能给用户带来真正有价值的信息。最后,站长必须妥善设置robots.txt文件,确保搜索引擎蜘蛛能够顺利抓取网站全部页面,从而避免因技术原因影响网站收录和排名。

唯有站长不懈追求并优化,以实用户受益之优质内容,方能获取搜索引擎认同,确保网站稳健长远发展。