摘要:第五集【搜索问答剧场】中,跟大家提到了【Robots】工具。3、Q:robots.txt中设置了禁止百度收录网站的内容,为何还出现在百度搜索结果中?——什么是【搜索问答剧场】?

面对互联网科技进步加速,网站抓取控制愈发关键。为此,本文详述了有效运用Robots工具以及适当设定网站抓取权的方法,力求保证您的网站在搜索引擎中取得最佳表现。

1.Robots工具简介

机器人技术在网站管理中的重要性不言而喻,其中最关键的即是利用robots.txt文件来设定搜索引擎蜘蛛的抓取范围与权限。作为搜索引擎蜘蛛访问网页的主要依据,遵循此项原则至关重要。

2.Robots.txt文件结构

robots.txt文件内含多条记录,各以User-agent、Disallow与Allow为重要元素。User-agent指定受众群体,Disallow通过URL范围限制爬虫操作;而Allow指令则旨在为特定期限的URL提供访问权限。

3.灵活设置抓取范围

利用robots.txt的灵活的Disallow和Allow规则,您能精准地规划搜索引擎爬虫的爬取范围。例如,通过Disallow特定目录或页面的索引,并允许特定信息被收录,进而实现精细化的网站爬取管理。

4.Robots工具的使用方法

凭借各大搜索引擎所提供的Robots实用工具如何禁止百度收录,网站管理者可便捷地创建、实时监控并定期更新符合标准规范的robots.txt文件。此工具具有卓越的文本检测功能,确保用户精确了解自身网站robots.txt的运行实况。同时,合理设定的文件容量与字符数量限制,亦保证了robots.txt文件的合规性与实效性。

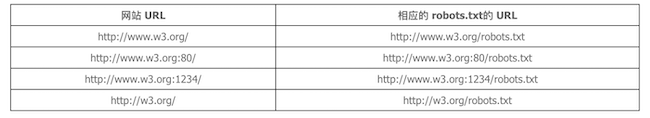

5.保证robots.txt文件的规范

为保证robots.txt文件的有效性和合理化,请遵循以下规则:首要原则是将其置于网站根目录,便于搜索引擎爬虫快速定位;其次,记录内容需清晰明了,为各种爬虫制定明确的规则,以防混淆和误解。

6.处理robots文件更新后的调整期

在更新robots.txt后如何禁止百度收录,搜索引擎无法立即调整其抓取策略,须经历1至2周左右的适应期方可。因此,请耐心等待各大搜索引擎对新规则做出反应并适时监控您的网站抓取状态。

7.处理robots文件生效延迟的情况

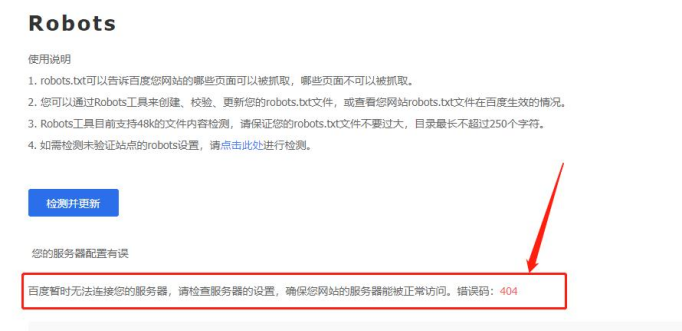

即便站长已明示免被索引之内容于robots.txt,但百度仍可能检索此等信息,其因多为robots文件无效或实施过程受阻。建议站长使用搜索引擎资源平台Robots工具即时监控robots文件的执行状况,借助错误编码深入剖析并加以修正。

8.解决robots文件生效延迟的方法

在面对robots文件延迟生效问题时,可采取以下两种方式以提升响应效率。首先,充分利用Robots工具中的"检测与更新"功能,引导搜索引擎蜘蛛更为高效地抓取内容。其次,深入研究如《网站误封robots处理方法》等相关资源,以获取有关robots文件延迟生效问题的解决策略。

9.站长应该关注的问题

为确保合理掌控网络爬虫抓取范围,管理者应特别重视机器人协议文件(Robots.txt)的标准化及实效性,做到适时更新与修订。同时,必须持续关注搜索引擎对该文件的解读情况,如遇到生效延时等问题,务必及时查明原因并加以修复,以保证站点最佳呈现效果。

10.向读者提出的问题

在利用机械人技术设置网页检索策略过程中,阁下是否有过何种棘手的挑战?请问是如何灵巧地应对并克服这些问题的?敬请分享贵司的珍贵经验与独到见解。